苹果公司在强化学习领域迈出了创新步伐,其研究人员最近提出了一种名为“基于清单反馈的强化学习”(RLCF)的新方法。这一方法旨在优化大语言模型(LLMs)处理复杂指令的能力,摒弃了传统的人类点赞或点踩评分模式。

RLCF,全称Reinforcement Learning from Checklist Feedback,它的核心在于为每个用户指令生成详细的检查清单,并根据0到100分的评分系统对每一项进行评判。这一改变,使得模型在优化过程中能够接收到更加具体和针对性的反馈,而非仅仅依赖于笼统的人类喜好。

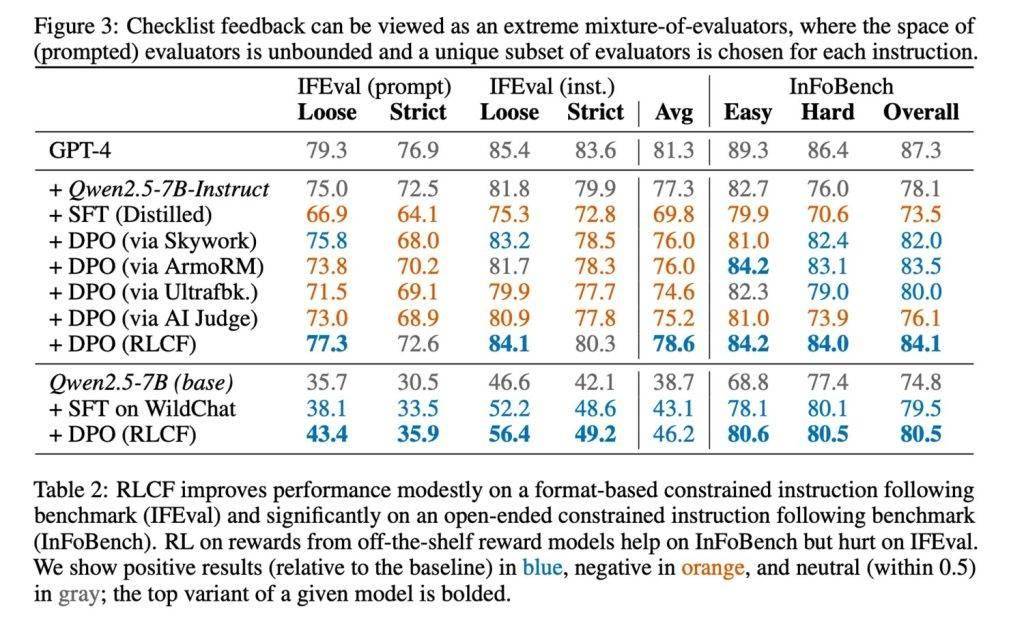

为了验证RLCF方法的有效性,研究团队在强指令跟随模型Qwen2.5-7B-Instruct上进行了测试,测试涵盖了五个常用的评测基准。结果显示,RLCF在所有测试中均取得了显著提升:FollowBench的硬性满意率提高了4个百分点,InFoBench提升了6点,Arena-Hard的胜率增加了3点,部分任务的最大提升甚至达到了8.2%。这些数据无疑证明了清单反馈在应对复杂、多步骤任务时的强大效果。

在清单的生成方面,苹果的研究团队也展现出了独到的见解。他们利用规模更大的Qwen2.5-72B-Instruct模型,结合现有的研究方法,为13万条指令创建了名为“WildChecklists”的数据集。这些数据集中的清单条目都是明确的二元判断项,例如“是否准确翻译为目标语言”。随后,大模型会对候选回答进行逐项评分,并将这些评分综合加权,作为小模型训练的奖励信号。

然而,苹果研究者也坦诚地指出了RLCF方法的局限性。首先,它依赖于性能更强的模型作为评判者,这在资源受限的环境下可能难以实现。其次,RLCF专注于提升复杂指令的执行能力,并未专门设计用于安全性对齐,因此不能替代安全性评估与优化。对于其他类型的任务,该方法的适用性仍需进一步的研究和验证。