DeepSeek近日推出新一代OCR模型DeepSeek-OCR 2,通过引入创新的DeepEncoder V2架构,突破了传统视觉-语言模型(VLM)的机械处理模式。该模型能够模拟人类视觉逻辑,动态解析图像内容结构,在复杂排版场景中展现出显著优势。这一技术突破标志着OCR领域从"像素识别"向"语义理解"的范式转变。

传统VLM模型普遍采用光栅扫描顺序处理图像,即从左上角到右下角逐块扫描。这种处理方式在面对多栏文档、混合排版报表等复杂场景时,往往难以准确捕捉内容间的逻辑关系。例如在处理包含公式与文字混排的科研论文时,传统模型可能将公式编号与相邻段落错误关联,导致语义理解偏差。

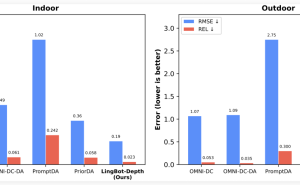

DeepSeek-OCR 2通过动态重组图像模块的创新机制,实现了真正的语义感知处理。该模型不再拘泥于固定扫描路径,而是根据内容语义自动调整处理顺序。在OmniDocBench v1.5基准测试中,新模型以91.09%的准确率刷新纪录,较前代提升3.73个百分点,在金融报表、法律文书等结构化文档处理中表现尤为突出。

技术团队通过优化视觉Token生成机制,将计算成本控制在合理范围。模型视觉Token数量严格限定在256-1120区间,与Google Gemini-3 Pro保持同等效率标准。实际生产测试显示,该模型处理在线用户日志的重复率下降2.08%,PDF预训练数据重复率降低0.81%,展现出卓越的工程实用性。

DeepEncoder V2架构的探索具有更深层的行业意义。该架构创新性地将语言模型架构应用于视觉编码,天然继承了大型语言模型(LLM)在混合专家(MoE)架构和高效注意力机制等方面的优化成果。这种跨模态架构融合为多模态大模型发展提供了新的技术路径,特别是在处理需要逻辑推理的视觉任务时展现出独特优势。