在科技界的瞩目之下,华为于近期举办的HDC 2025开发者大会上,展现了其在人工智能(AI)领域的雄心壮志与显著进步。AI成为此次大会的绝对焦点,不仅华为云推出了新一代昇腾AI云服务和全面迭代的盘古大模型5.5,华为终端也首次亮相鸿蒙智能体框架,旨在打造端侧智能体生态的新篇章。

近年来,高端AI芯片的供应挑战一度限制了华为在AI领域的步伐。尽管华为已构建以盘古大模型为核心的AI技术体系,但其整体实力尚未达到顶尖水平。然而,经过两年的深耕与积累,随着自研AI算力体系的迅猛提升,盘古大模型的核心竞争力正逐步逼近GPT、Gemini、Deepseek等国际领先玩家。

在HDC 2025大会上,华为云发布的两大AI核心成果尤为引人注目:新一代盘古大模型5.5和支撑其训练的新一代昇腾AI云服务。盘古大模型5.5对其五大基础模型——自然语言处理(NLP)、计算机视觉(CV)、多模态、预测、科学计算——进行了全面革新。其中,盘古NLP大模型推出了全新的718B深度思考模型,该模型在知识推理、工具调用、数学等关键能力上实现了显著增强,并通过自适应快慢思考合一技术,使整体推理效率提升了8倍。

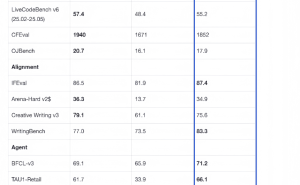

盘古大模型5.5还推出了深度研究DeepDiver,能够在网页搜索、常识性问答等应用上展现出极高的执行效率,大幅提升工作效率。盘古Pro MoE模型在第三方跑分测试SuperCLUE榜单上,在知识推理、工具调用、数学、对话、代码、自然科学六大领域,其跑分成绩已接近甚至在某些领域超越了GPT、Gemini、Deepseek等顶尖模型。这一成就不仅彰显了华为在AI技术上的突破,更证明了基于全自研AI服务器的华为,能够训练出与世界顶尖水平相当的大模型。

在算力方面,华为云基于CloudMatrix 384超节点发布了新一代昇腾AI云服务。该服务通过创新的架构,将384颗昇腾NPU和192颗鲲鹏CPU通过全新高速网络MatrixLink全对等互联,形成一台超级“AI服务器”,单卡推理吞吐量跃升至2300 Tokens/s,与非超节点相比提升近4倍。这一突破性的架构能够更好地支持混合多专家MoE大模型的推理,极大提升效率,并将算力有效使用率(MFU)提升50%以上。

面向C端用户,华为终端在HDC 2025期间发布了鸿蒙6.0开发者Beta版,并首次推出鸿蒙智能体框架(HMAF)。这一框架不仅是一个开发工具,更是构建在鸿蒙系统和华为AI底座上的一整套AI生态系统。开发者可以利用鸿蒙智能体框架,通过鸿蒙系统分发或集成到鸿蒙AI助手小艺中,为用户提供更加智能、便捷的服务体验。已有高德、大众点评、京东、微博等超过50个鸿蒙智能体即将上线鸿蒙平台。

在B端领域,华为通过盘古大模型赋能千行万业,提升其生产力。盘古大模型已广泛应用于医疗、金融、政务、工业等多个领域,推出了一系列行业解决方案。例如,盘古预测大模型在钢铁、有色金属、供热等行业取得了显著成效,宝武钢铁高炉大模型上线后,出铁温度合格率稳定在90%以上,每吨铁水可节省2公斤燃料。盘古科学计算大模型也被用于提升天气预报的精准度,而最新的盘古世界模型则通过构建数字物理空间,辅助智能驾驶和具身智能机器人的训练。

在具身智能领域,华为云基于盘古大模型的多模态能力及思维能力,正式发布了CloudRobo具身智能平台。该平台整合了端到端能力,提供三大核心模型,加速具身智能创新。同时,面对具身智能领域的诸多挑战,华为云提出了机器人到云的联接协议R2C(Robot to Cloud),为具身智能的发展提供了有力支持。

华为在HDC 2025开发者大会上的这一系列发布,不仅展示了其在AI领域的显著进步,更彰显了其将自研能力转化为赋能千行万业智能化升级的决心与实力。随着鸿蒙智能体框架和盘古大模型的深入应用,华为正引领着AI技术的新一轮变革,开启智能化升级的新篇章。